오랜만에 주목할 만한 새로운 오픈소스 이미지 생성 모델이 출시되어 직접 리포트를 읽고 분석해보았다. 이번 모델이 6B 정도의 사이즈인데 32B 크기의 Flux.1 를 이기는 성능을 보여주었기 때문에 더 흥미가 생겼고 앞으로의 로컬 이미지 생성의 새로운 표준이 될 가능성이 보이는거 같다.

소개

Z-Image는 Alibaba Cloud의 Tongyi Lab에서 개발하여 2025년 11월 말에 공개한 최신 텍스트-이미지 생성 모델입니다. 이 모델은 기존의 거대 모델 트렌드(20B+ 파라미터)와 달리 60억 개(6B)의 파라미터만으로 최상위권의 생성 품질을 달성하는 '효율성'에 초점을 맞추었습니다.

모델 패밀리

| 모델 명 | 주요 특징 및 목적 |

|---|---|

| Z-Image-Turbo | 주력 모델. 추론 속도에 최적화된 증류(Distilled) 버전. 단 8 Step으로 생성 가능하며 소비자용 GPU(RTX 30/40 시리즈) 및 엔터프라이즈(H800 등)에서 초고속 추론 지원. |

| Z-Image-Base | 증류되지 않은 파운데이션 모델. 커뮤니티의 파인튜닝(Fine-tuning) 및 추가 연구 개발을 위한 기본 베이스. |

| Z-Image-Edit | 이미지 편집(Editing)에 특화된 모델. 인스트럭션 팔로잉(Instruction-following) 능력이 강화되어 복잡한 편집 명령 수행 가능. |

핵심 기술은 S3-DiT (Scalable Single-Stream Diffusion Transformer) 아키텍처와 DMD/DMDR이라는 새로운 증류(Distillation) 기법을 도입하여, 단 8회의 샘플링 단계(Steps) 만으로 고품질 이미지를 생성할 수 있다는 점입니다. 이는 소비자용 GPU(16GB VRAM)에서도 원활한 구동을 가능하게 하여 접근성을 혁신적으로 높였습니다.

데이터 인프라

Z-Image는 최대 효율성을 위해서 단순 데이터양을 늘리는 것보다 데이터에 최대한 많은 정보를 담기 위해서 여러 전략을 도입했습니다.

4대 핵심 모듈

1. 데이터 프로파일링 엔진 (Data Profiling Engine):

이미지 메타데이터, 기술적 품질(압축 아티팩트, 노이즈 등), 미적 점수, 의미적 태그 등을 다차원적으로 추출.

자체 VLM(Vision-Language Model)을 사용하여 OCR 정보를 포함한 상세 캡션을 생성하여 텍스트 렌더링 능력을 강화.

1.1. 기본 메타데이터 및 중복 제거

- Perceptual Hash (pHash): 이미지의 바이트 스트림을 기반으로 지각적 해시를 계산하여 '시각적 지문(Visual Fingerprint)'을 생성합니다. 이를 통해 비트 단위로 동일하지 않더라도 시각적으로 유사한 중복 이미지를 $O(1)$ 복잡도로 빠르게 제거합니다.

1.2. 기술적 품질 평가 (Technical Quality Assessment)

저품질 데이터를 사전에 차단하기 위해 3단계 기술적 검증을 수행합니다.

- 압축 아티팩트 (Compression Artifacts): (해상도 및 비트 심도 기반 이상적 파일 크기) / (실제 파일 크기) 비율을 계산하여 과도한 압축으로 인한 손실을 감지합니다.

- 정보 엔트로피 (Information Entropy):

- Border Variance: 테두리 픽셀의 분산을 분석하여 단색 배경이나 불필요한 프레임이 많은 이미지를 필터링합니다.

- BPP (Bytes-Per-Pixel): 일시적인 JPEG 재인코딩을 수행하고 그 결과의 BPP를 측정하여 이미지의 복잡도(Complexity)와 정보 밀도를 정량화합니다.

- 시각적 열화 (Visual Degradations): 자체 학습된 품질 평가 모델(IQA)을 통해 색조(Color Cast), 블러(Blur), 노이즈(Noise), 워터마크 등을 점수화합니다.

1.3. 의미론적 및 미적 평가 (Semantic & Aesthetic Profiling)

- AIGC 탐지 (AI-Generated Content Detection): Imagen 3의 연구 결과를 반영하여, AI가 생성한 이미지를 분류기로 탐지하고 제거합니다. 이는 모델이 **재귀적 학습(Recursive Training)**으로 인해 현실감(Physical Realism)을 잃고 품질이 저하되는 것을 방지하기 위함입니다.

- VLM 기반 태깅 (High-Level Semantic Tagging): VLM을 활용하여 객체 카테고리, 사람 수, 문화적 요소(특히 중국 문화), NSFW(안전성) 점수를 추출합니다.

- OCR 통합 캡셔닝: 기존 연구들과 달리 별도의 OCR 모듈을 두지 않고, VLM에게 이미지 내의 텍스트와 워터마크를 설명하도록 프롬프팅하여 캡션 생성 시 텍스트 정보를 통합합니다. 이는 텍스트 렌더링 성능 향상의 핵심입니다.

2. 크로스 모달 벡터 엔진 (Cross-modal Vector Engine):

수십억 개의 임베딩을 기반으로 의미론적 중복 제거(Semantic Deduplication) 수행.

유사도 검색을 통해 모델 실패 케이스를 진단하고 부족한 개념을 보완.

2.1. 그래프 기반 커뮤니티 탐지 (Graph-based Community Detection)

Stable Diffusion 3의 중복 제거 방식을 개선하여 확장성 병목을 해결했습니다.

- 알고리즘 최적화: 기존의 느린 range_search 함수를 k-NN (k-Nearest Neighbor) 검색으로 대체했습니다.

- 근접 그래프(Proximity Graph): k-NN 거리 기반으로 그래프를 구축하고, **커뮤니티 탐지 알고리즘(Louvain/Leiden 등)**을 적용하여 의미적으로 밀집된 클러스터를 식별합니다.

- GPU 가속: RAPIDS cuGraph 라이브러리 등을 활용하여 H800 GPU 8개로 10억 개 아이템을 약 8시간 만에 처리(인덱스 구축 + 100-NN 쿼리)하는 파이프라인을 구축했습니다.

2.2. 진단 및 복구 (Diagnosis & Remediation)

- 모델 실패 진단: 모델이 생성에 실패한 케이스(Bad Generation)나 잘못 이해한 프롬프트가 발생하면, 이 엔진을 통해 해당 오류를 유발한 데이터 클러스터를 역추적하여 제거(Pruning)합니다.

- 개념 공백 보완: 반대로 벡터 공간상에서 밀도가 낮은 영역(Void)을 찾아내어, 해당 개념을 보완할 수 있는 데이터를 전략적으로 샘플링합니다.

3. 세계 지식 위상 그래프 (World Knowledge Topological Graph):

Wikipedia의 하이퍼링크 등을 기반으로 계층적 지식 그래프 구축.

- Phase 1 (초기 구축 및 이중 필터링): 위키피디아의 방대한 엔티티 연결 구조에서 PageRank 알고리즘으로 중요도가 낮은 고립된 노드를 제거하고, VLM 검증기를 통해 시각화가 불가능한 추상적 개념을 필터링하여 그래프의 기초 골격을 형성합니다.

- Phase 2 (계층적 확장 및 구조화): 대규모 내부 캡션 데이터셋의 태그 임베딩을 기반으로 계층적 클러스터링을 수행하고, VLM이 하위 자식 노드들의 내용을 요약해 상위 노드명을 자동 생성함으로써 정교한 의미론적 분류 체계(Taxonomy)를 구축합니다.

- Phase 3 (동적 조정 및 최적화): 실제 사용자 프롬프트에서 빈번하게 등장하는 개념의 가중치를 상향 조정하고, 기존 데이터 풀에 부재한 최신 트렌드나 신규 엔티티를 능동적으로 주입하여 그래프의 시의성과 실용성을 동적으로 최적화합니다.

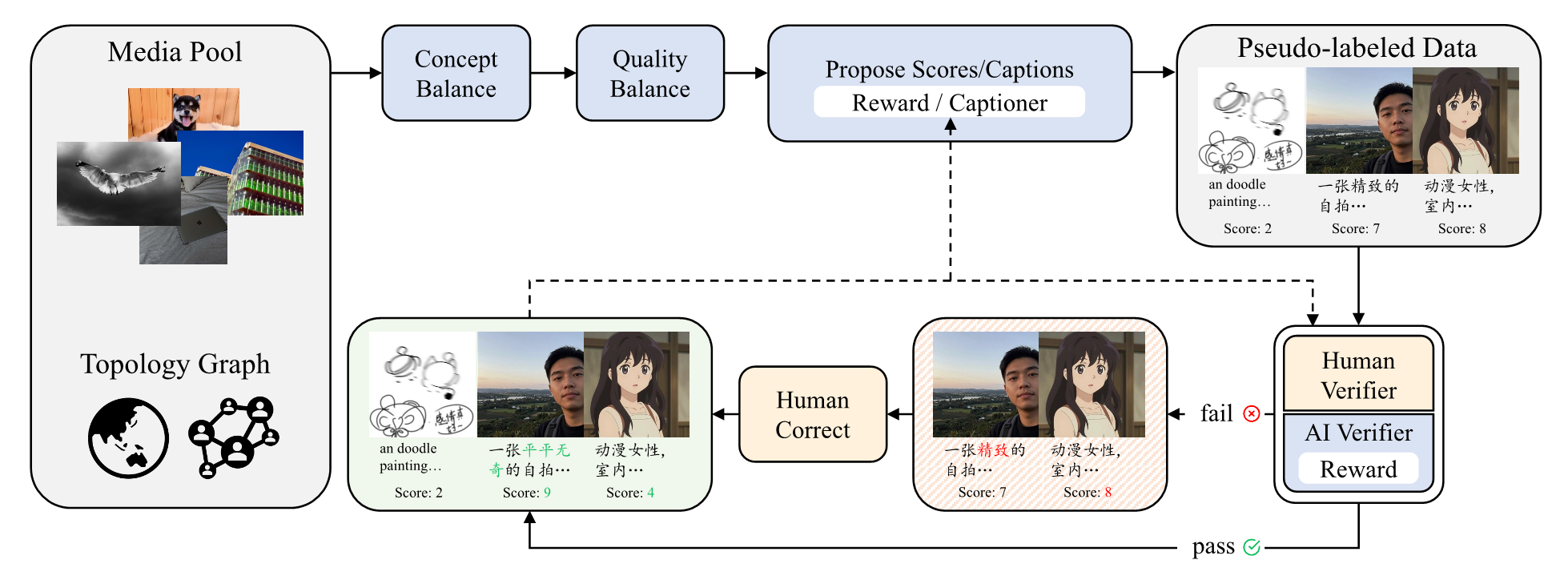

4. 능동적 큐레이션 엔진 (Active Curation Engine):

모델의 성능이 낮은 'Hard Case'를 식별하고, Human-in-the-loop 피드백 루프를 통해 데이터 품질을 지속적으로 개선.

이미지 편집 데이터 구축

1. 효율적인 그래픽 표현 및 조합론적 확장 (Efficient Graphical Representation)

이 방법론의 핵심은 단일 입력 이미지로부터 생성된 여러 편집 버전을 그래프의 노드(Node)로 보고, 이들 간의 연결(Edge)을 통해 새로운 학습 데이터를 창출하는 것입니다.

- 1-to-N 확장 (Expert Model Utilization):하나의 입력 이미지($I$)에 대해, 여러 종류의 '전문가 모델(Task-specific Expert Models)'을 사용하여 $N$개의 서로 다른 편집 버전($E_1, E_2, ..., E_N$)을 생성합니다.

예를 들어, $I$를 입력받아 스타일을 변경한 $E_1$, 객체를 추가한 $E_2$, 배경을 바꾼 $E_3$를 생성합니다.조합론적 쌍 생성 (Combinatorial Permutation):단순히 $I \rightarrow E_k$ 관계만 학습하는 것이 아니라, 생성된 $N$개의 버전과 원본 $I$를 포함한 집합 내에서 임의의 두 이미지를 선택하여 쌍(Pair)을 구성합니다.- 데이터 증강 공식: 1개의 원본과 $N$개의 편집본이 있을 때, 생성 가능한 편집 쌍의 수는 $2\binom{N+1}{2}$개로 확장됩니다. 이는 데이터 구축 비용을 사실상 'Zero Cost'로 낮추면서 데이터 규모를 확장하는 효과를 줍니다.

- 혼합 편집 및 역방향 학습 (Mixed & Inverse Editing):Mixed Editing: 서로 다른 편집본 $E_a$와 $E_b$를 쌍으로 묶으면, 모델은 한 번에 복합적인 변화(예: 스타일 변경 + 객체 추가)를 학습하게 됩니다. 이는 단일 태스크 학습보다 훈련 효율을 높입니다.

- Inverse Pairs: 편집된 이미지($E_k$)를 입력으로, 원본 이미지($I$)를 출력으로 설정하여 학습하면, 모델은 왜곡되거나 편집된 이미지를 원본으로 복원하는 능력을 학습하게 되어 데이터 품질과 모델의 강건성(Robustness)을 향상시킵니다.

2. 비디오 프레임 기반의 자연적 쌍 구축 (Paired Images from Videos)

인위적인 편집뿐만 아니라, 자연스러운 물리적 변화를 학습하기 위해 비디오 데이터를 활용합니다.내재적 관계 활용: 비디오의 연속된 프레임들은 동일한 피사체나 장면을 공유하면서도 시점, 조명, 포즈 등의 내재적 연관성(Inherent Relatedness)을 가집니다. 이는 자연스러운 '편집 관계'로 정의될 수 있습니다.의미론적 필터링 (Semantic Filtering):단순 프레임 추출은 노이즈가 많으므로, CN-CLIP을 사용하여 이미지 임베딩 간의 코사인 유사도(Cosine Similarity)를 계산합니다.의미적으로 높은 관련성을 가지면서도 시각적 변화가 있는 프레임 쌍만을 선별하여, 복합적인 편집(예: 사람의 포즈 변경과 배경 변화가 동시에 일어나는 경우) 능력을 학습시킵니다.

3. 텍스트 편집을 위한 렌더링 파이프라인 (Rendering for Text Editing)

자연 이미지(Natural Images)는 텍스트 분포가 희소하고 불균형하여 텍스트 편집 학습에 부적합합니다. 이를 해결하기 위해 합성 데이터 전략을 사용합니다.제어 가능한 텍스트 렌더링 (Controllable Text Rendering):폰트, 색상, 크기, 위치 등 시각적 속성을 완벽하게 제어할 수 있는 렌더링 시스템을 구축합니다.

- Ground-Truth 확보: 렌더링 엔진을 통해 이미지를 생성하므로, 입력 이미지와 출력 이미지 간의 차이(편집 명령)를 100% 정확하게 알 수 있습니다.이를 통해 "파란색 박스 안의 글자를 변경해줘"와 같은 정밀한 텍스트 편집 명령을 수행할 수 있는 대규모 데이터셋을 구축했습니다.

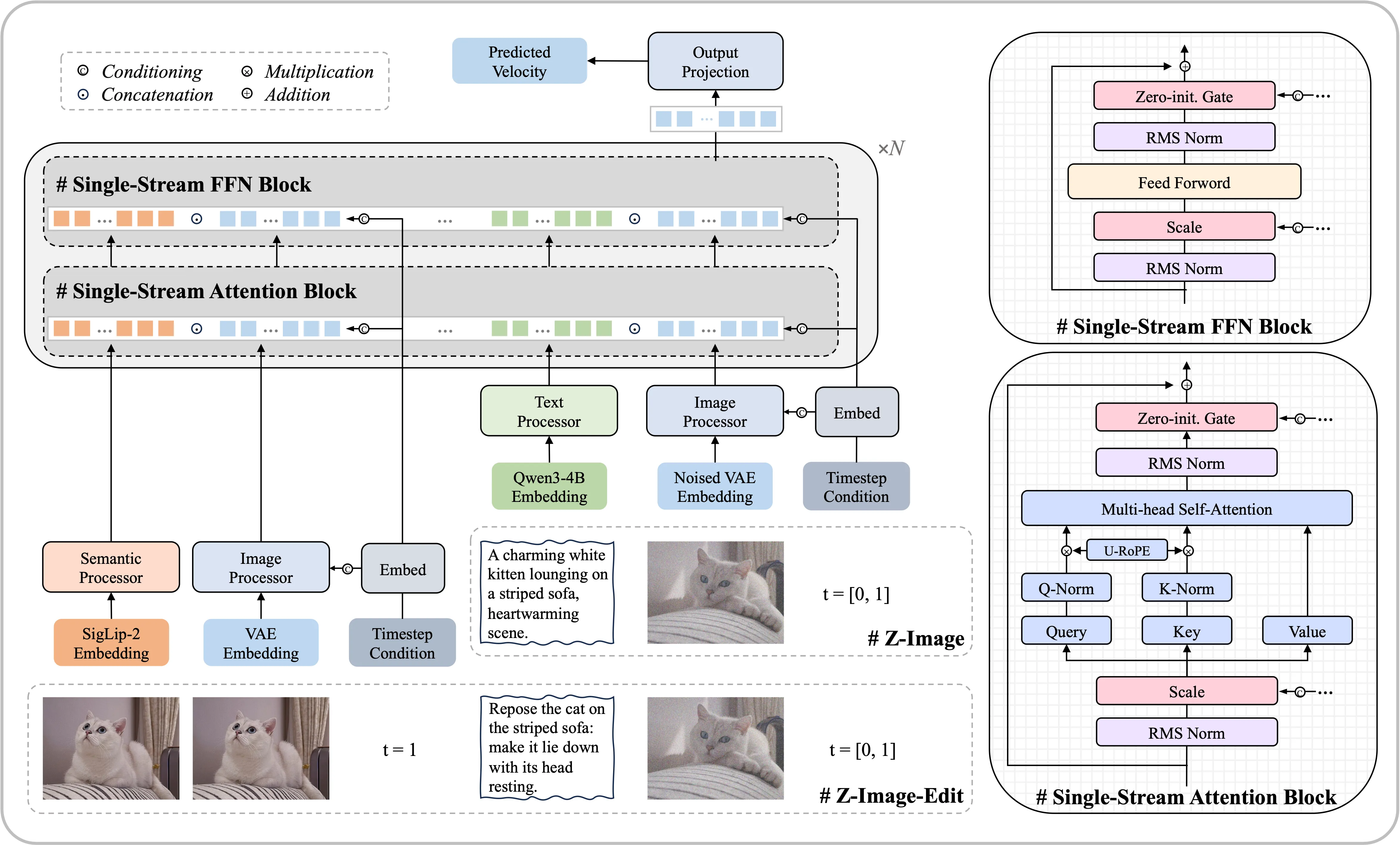

아키텍처

Z-Image는 Flux.1 과 같은 Flow Matching 기반 생성 모델이지만 구조가 다르다. 기존의 많은 모델(예: SDXL, Qwen-Image 등)은 텍스트와 이미지를 별도의 스트림으로 처리하다가 중간에 교차 어텐션(Cross-Attention)으로 정보를 교환하는 Dual-stream 구조를 채택했습니다. 반면, Z-Image는 LLM의 디코더 전용(Decoder-only) 아키텍처의 성공에 영감을 받아, 모든 모달리티를 하나의 통합된 시퀀스(Unified Sequence)로 처리하는 Single-Stream 구조를 채택했습니다.

핵심 포인트: 텍스트 토큰, 이미지 VAE 토큰, 시각적 의미 토큰(편집용)을 직렬로 연결(Concatenation)하여 단일 트랜스포머 블록에 입력합니다. 이는 모달리티 간의 상호작용(Interaction)을 매 레이어마다 조밀하게 수행하게 하며, 파라미터 효율성을 극대화합니다.

아키텍처 요약

- 입력 처리: 텍스트 토큰, 이미지 VAE 토큰, 시각적 의미 토큰을 하나의 시퀀스로 연결하여 처리.

- 구성 요소:

- Text Encoder: Qwen3-4B (이중언어 능력 활용).

- Image VAE: Flux VAE (복원 품질 우수).

- Semantic Processor(Vision Encoder): SigLIP 2 (편집 작업 시 참조 이미지의 추상적 의미 포착).

- 위치 임베딩 (Positional Embedding): 3D Unified RoPE를 사용하여 이미지 토큰은 공간 차원으로, 텍스트 토큰은 시간 차원으로 확장하여 혼합 시퀀스를 모델링.

정규화 및 안정성 테크닉

- QK-Norm: 어텐션(Attention) 연산 전, Query와 Key 벡터에 LayerNorm을 적용하여 어텐션 스코어의 발산(Activation Blowing up)을 방지합니다.

- Sandwich-Norm: 각 Attention 및 FFN 블록의 입력과 출력 모두에 정규화를 적용하여 신호의 진폭(Amplitude)을 제어합니다.

- RMSNorm: 모든 정규화에는 계산 효율성이 높은 RMSNorm[92]을 사용합니다.

조건 주입 메커니즘 (Conditioning Injection)

타임스텝(Timestep)이나 텍스트 조건 등은 AdaLN-Zero와 유사한 방식으로 주입되지만, 파라미터 효율성을 위해 최적화되었습니다.

- Scale & Gate: 입력 조건 벡터(Condition Vector)를 투영(Projection)하여, 정규화된 입력값에 적용할 스케일(Scale) 파라미터와 게이트(Gate) 파라미터를 생성합니다.

- Low-Rank Decomposition: 파라미터 오버헤드를 줄이기 위해, 이 투영 레이어를 LoRA(Low-Rank Adaptation)와 유사하게 분해했습니다.

- Shared Down-projection: 모든 레이어가 공유하는 다운 프로젝션.

- Layer-specific Up-projection: 각 레이어별로 고유한 업 프로젝션.

학습 파이프라인

전체 학습 과정은 비용 효율성을 극대화하기 위해 단계적으로 설계되었습니다.

1. 사전 학습 (Pre-training)

사전 학습의 경우 2단계로 나누어 비용 효율적으로 학습을 진행했습니다.

- Low-resolution Pre-training: $256^2$ 해상도에서 시각적-의미적 정렬 및 기초 지식 습득에 집중.

- Omni-pre-training:

- 임의 해상도 학습: 다양한 종횡비와 해상도 처리.

- 멀티 태스크 학습: Text-to-Image와 Image-to-Image(편집) 작업을 통합하여 학습. 별도의 편집 모델 학습 비용 절감.

- 다중 레벨, 다중 언어 캡션 학습: 다중 언어 이해와 강력한 프롬프트 이해도를 위해서 Z-Captioner를 사용하여 다언어, 멀티 레벨 캡션 합성(long, medium, short 길이의 캡션)을 적용

2. 지도 미세 조정 (SFT)

- Distribution Narrowing: 사전 학습의 넓은 분포를 고품질/고충실도 분포로 축소.

- Prompt Enhancer (PE): 6B 모델의 지식 한계를 극복하기 위해 VLM 기반의 프롬프트 강화 모듈을 도입. 추론(Reasoning) 체인을 포함하여 복잡한 사용자 의도를 상세한 묘사로 변환.

소수 단계 증류 (Few-Step Distillation) - Z-Image-Turbo

추론 속도를 획기적으로 줄이기 위해 Base 모델을 증류한 8 Step 생성 모델 (Z-Image-Turbo)을 구축했습니다. 기존 DMD(Distribution Matching Distillation)의 한계를 극복하기 위해 두 가지 핵심 기술을 도입했습니다.

- Decoupled DMD: 증류 과정에서 품질 향상(Quality-enhancing)과 학습 안정화(Training-stabilizing) 역할을 분리하여 고주파 디테일 손실 및 색상 변이 문제 해결.

- DMDR (Distribution Matching with RL): 분포 매칭 항(Term)을 정규화 도구로 사용하여 강화 학습(RL)을 통합. 이를 통해 보상 해킹(Reward Hacking)을 방지하면서 심미적 품질 최적화. Distribution Matching Distillation Meets Reinforcement Learning 논문 링크

RLHF (인간 피드백 기반 강화 학습)

Z-Image 팀은 SFT(Supervised Fine-Tuning) 이후 모델이 여전히 인간의 미세한 선호도(뉘앙스, 심미성)나 복잡한 지시사항을 완벽히 따르지 못하는 한계를 극복하기 위해, 2단계(Two-stage) 포스트 트레이닝 전략을 설계했습니다. 이 전략은 오프라인 DPO와 온라인 GRPO를 결합하여 객관적 성능과 주관적 품질을 순차적으로 최적화하는 것이 핵심입니다.

- Stage 1 (DPO): 텍스트 렌더링, 객체 수 등 객관적 지표에 대해 VLM을 활용한 오프라인 정렬 수행.

- Stage 2 (GRPO): 심미성 등 주관적 품질 향상을 위해 온라인 미세 조정 수행.

Stage 1: 객관적 차원에 대한 오프라인 DPO (Offline Alignment)

첫 번째 단계는 DPO (Direct Preference Optimization)를 사용합니다. 하지만 기존 DPO가 겪는 '고품질 선호 쌍(Preference Pair) 데이터 확보의 병목 현상'을 해결하기 위해 "객관적 지표 중심의 자동화" 전략을 채택했습니다.

- 주관성 배제 및 VLM 활용

미적 품질과 같은 주관적 영역은 데이터 수집 비용이 높고 노이즈가 심합니다. 따라서 Stage 1에서는 명확한 정답이 있는(Binary correctness) 객관적 차원에 집중합니다.

대상: 텍스트 렌더링(Text Rendering), 객체 수 세기(Object Counting) 등.

자동화 파이프라인: VLM(Vision-Language Model)을 활용하여 대규모로 후보 쌍을 생성합니다.- Chosen (Positive): 오탈자 없이 텍스트가 렌더링된 이미지.

- Rejected (Negative): 철자 오류(Typo)나 렌더링 실패가 있는 이미지.

이후 하이브리드 검증(인간+AI)을 통해 데이터의 무결성을 확보합니다.

- 커리큘럼 학습 (Curriculum Learning)

DPO 학습 효율을 높이기 위해 난이도를 조절하는 커리큘럼 전략을 도입했습니다.- 난이도 점진적 증가: '단일 단어 렌더링' 같은 단순 태스크에서 시작하여, '복합 요소/복잡한 레이아웃' 등 고난도 태스크로 진행합니다.

- 쌍(Pair) 차별성 조절:

- 초기: 정답과 오답의 차이가 명확한 데이터로 학습.

- 후기: 미세한 차이(Subtle differences)만 존재하는 어려운 쌍을 학습시켜 모델의 변별력을 극대화하고 수렴 속도를 가속화합니다.

Stage 2: 온라인 GRPO를 통한 미세 조정 (Online Refinement)

DPO를 통해 객관적 성능(지시 이행)이 확보된 모델을 베이스로, GRPO (Group Relative Policy Optimization)를 적용하여 주관적 품질(심미성, 사실성)을 극대화합니다.

- GRPO 메커니즘

PPO(Proximal Policy Optimization)와 달리, 별도의 가치 모델(Value Model) 없이 그룹 내 상대적 우위를 기반으로 정책을 업데이트하여 메모리 효율성을 높입니다.

그룹 생성: 하나의 프롬프트에 대해 모델이 여러 개의 출력물 그룹 ${y_1, y_2, ..., y_G}$을 생성합니다

다차원 피드백: 보상 모델이 각 출력물에 대해 여러 차원(사실성, 심미성, 지시 이행 등)의 점수를 매깁니다.

복합 이점 함수 (Composite Advantage Function):

단일 보상에 최적화할 경우 다른 지표가 하락하는 문제(예: 화려하지만 지시를 무시함)를 방지하기 위해, 여러 보상 점수를 집계(Aggregation)하여 종합 점수를 산출합니다.

그룹 내 평균 대비 해당 출력물의 우위(Advantage)를 계산하여 정책을 업데이트합니다. - 효과: Reward Hacking 방지 및 균형 달성

이 방식은 보상 모델의 허점을 파고들어 점수만 높고 품질은 낮은 이미지를 생성하는 보상 해킹(Reward Hacking)을 효과적으로 억제합니다.

성능 평가 (Performance Evaluation)

정량적 평가

- 텍스트 렌더링: CVTG-2K 및 LongText-Bench에서 영어 및 중국어 렌더링 모두 최상위권 성능 기록. 특히 Z-Image-Turbo는 효율성 대비 높은 정확도 유지.

- GenEval & DPG-Bench: 복잡한 프롬프트 따르기 및 객체 생성 능력에서 Qwen-Image(20B) 등 거대 모델과 대등하거나 능가하는 성능 발휘.

- Alibaba AI Arena (Elo Rating): 전체 4위, 오픈소스 모델 중 1위 기록 (Imagen 4 Ultra, Seedream 4.0 등과 경쟁).

결론

- Z-Image 는 간만에 정말 쓸만한 차세대 오픈소스 경량 DiT 이미지 생성 모델이 나왔다는 평가를 내릴수 밖에 없는거 같다. 데이터셋 구축과 전처리부터 많은 노력을 기울인거 같고, 절대적인 성능도 6B 사이즈의 모델임에도 굉장히 뛰어나며, Turbo 모델의 성능도 DMDR이라는 새로운 방법을 도입하여 Distillation 한 것치고 성능이 아주 뛰어났다.

- 텍스트 생성 능력은 영어와 중국어 생성은 아주 좋았는데 한국어는 데이터가 적어서 그런지 간단한 글자 정도만 가능했다. 앞으로 한국어 데이터셋으로 파인튜닝을 한다면 충분히 성능을 개선할 수 있을것 같다.

- 생성 속도도 개선의 여지가 있는것이 Distillation에 더해서 앞으로 Nunchaku 등 4bit 양자화를 적용하여 더 가속한다면 기존 SDXL 처럼 빠르게 생성할 수 있을거 같다.

군대에서 시간 없다는 핑계로 블로그 포스팅을 미루다가 전역하고 오랜만에 블로그 글을 썼는데 개인 노트에만 적어놓은 내용도 블로그에도 다시 꾸준히 쓰도록 해야겠다.

Reference

'AI' 카테고리의 다른 글

| [딥러닝] 클래스 밸런싱의 여러 방법과 Stable Diffusion 데이터셋의 멀티 레이블 클래스 밸런싱 (0) | 2023.09.11 |

|---|---|

| Stable Diffusion WebUI에서 프롬프트만으로 과적합된 모델을 살리는 팁(Prompt Editing) (0) | 2023.03.10 |

| [딥러닝]Stable Diffusion에서 너무 어두운 이미지를 학습하지 못하는 이유와 해결 방법(noise offset에 대하여) (0) | 2023.03.04 |

| [딥러닝 연구] Classifier-Free-Guidance(CFG)와 Stable diffusion 파인튜닝 (0) | 2023.02.18 |

| [딥러닝]Text to Image 모델 드림부스 학습의 Diversity를 높이는 방법 (4) | 2023.02.01 |